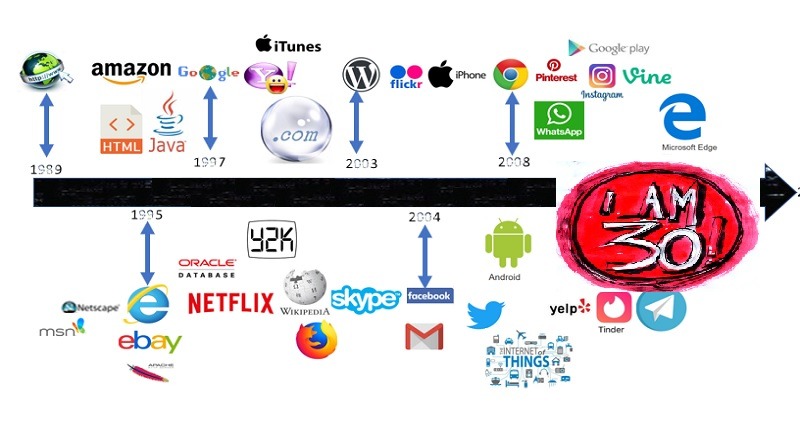

Avant-hier, le WEB a fêté en grandes pompes son anniversaire, et pas des moindres. Parce que 30 ans, c’est pas mal … trente ans, ce sont les premiers cheveux blancs, les premières rides, les premières émulsions de sagesse, aussi.

Puis je me suis rendue compte que ça faisait longtemps que je n’avais pas parlé de mon métier sur ce blog, un brin délaissé. Tous les blogs sont aujourd’hui plus ou moins délaissés, merci les GAFA.

Il y a dix ans, j’aimais bien me poser une heure ici pour discuter sociologie du web, comment il pouvait évoluer : j’avais vu éclore le web 2.0, celui qui dans son entière utopie, permettait le partage, le commentaire, la diffusion plus facile, voire automatisée. C’est une époque où les spécialistes du web essayaient d’imaginer le web 3.0 … pariant sur un web sémantique.

Cf : Analyse de la bulle Web 2.0

Aujourd’hui force est de constater que ce web libre, d’échange de partage et de contribution n’est pas si présent qu’on l’eut cru. Certes il est présent sur les plates-formes de réseaux sociaux, Facebook en tête, cf. Pourquoi Facebook va dominer le www …. et puis ça aussi : Avancée vers le micro-blogging

Le web : ce métier qui avance tel un TGV

En dix ans, nous avons vu bien entendu croitre le taux d’utilisateurs d’internet, qui ont changé d’habitudes d’utilisation : si avant l’ordinateur était indispensable, aujourd’hui c’est 50% de surfeurs qui utilisent leur smartphone ou leur tablette, obligeant ainsi les développeurs à innover … c’est ainsi que se sont démocratisés Twitter Bootstrap, la notion de Responsive Design, mais également des frameworks, rendant un code plus clair et maintenable, créant ainsi la notion de dette technique : fini le site « codé à la va-vite, mais qui marche ». Les langages se sont adaptés, comme PHP, qui est devenu un langage plus précis, optimisé. Les avancées sont telles que ces outils ne sont plus forcément utilisés pour des sites web, mais carrément pour des applications web. Ce qui nous permet à nous, développeurs web, d’étendre nos champs de compétences, et ce qui a divisé le métier : aujourd’hui nous pouvons parler de « développeur full-stack » (il gère les outils de gestion de contenus et leur affichage), « développeur back-end » (qui ne gère que les outils de gestion de contenu), « développeur front-end (qui ne gère que l’affichage) », et puis le touche-à-tout « devOps » (qui fait du développement mais aussi de la gestion de serveur, de l’intégration continue etc …). L’intégration continue est arrivée avec cette explosion d’utilisateurs : car il est question de nos jours de parler de forte charge, de tests unitaires et tests fonctionnels pour débarrasser tout bug qui puisse décourager un visiteur. Il faut maximiser les efforts, rendant le métier de plus en plus exigeant. Mais pour quelle finalité ?

Si les développeurs s’amusent en essayant un nouveau Framework en train de sortir, débattent pour savoir si PHP c’est mieux que GO, si NodeJS n’a pas été qu’un truc à la mode, derrière il y a des gens et des comportements.

Un web pas si décentralisé …

Le web2.0 était-il une utopie ? car si nous excluons ces fameux GAFA, que reste-il finalement à part des sites corporate ? Quid des blogs qui nous permettaient la création de cette ideosphère d’informations, ce regroupement de communautés, si cher dans nos esprits en 2007 ?Car le nouveau web repose sur ces géants, Google, Apple, Facebook, Amazon. Nous avons vu éclore lé métier de « Youtubeur » qui partage sa vie et ses opinions via rétribution de l’entreprise. Nous n’échappons pas au slogan « mets un petit pouce bleu ! ». Et derrière il y a tout un merchandizing : car quiconque est aspiré par une page Facebook, se promène sur le compte Youtube (ou inversement) pour atterrir sur une page Web qui contiendra un plug-in pour acheter des goodies sur … Amazon. Le web repose entièrement sur ces 4 firmes et laisse peu de chances à la concurrence. IL FAUT SE FAIRE CONNAITRE SUR FACEBOOK, YOUTUBE. Et les gens vont donner leur avis sur Facebook et Youtube, et un peu sur Twitter et Instagram (groupe Facebook, rappelons-le), et toute l’e-réputation vient de là. Car remarquez-bien : la plupart des sites web d’information ont supprimé le post de commentaires, l’information est redevenue bilatérale.

Sans compter le plus grave : ces organismes ont le malheur d’accéder à ces contenus, mais il se permettent aussi de juger et censurer !!! Cependant, le partage d’informations via ces plate-formes et beaucoup plus facile que toute une procédure de création de site … donc les gens y restent présents, et tout est fait pour simplifier le « travail » des gens qui publient : panneaux avec phrases toutes faites, boutons, like etc …

Si en 2010, le commentaire pertinent sur les blogs, en réponse à des billets argumentés, joutes oratoires entre blogueurs, était ce qu’il faisait la force potentielle de ce web 2.0 en 2007, on remarque hélas qu’en contrepartie, en 2017 il n’y avait plus beaucoup de sites d’informations qui proposaient cette fonctionnalité, alors que Google se sert des liens contenus dans nos propres sites pour propulser le référencements des sites mentionnés dans ces commentaires, et permettait justement une promotion de cette décentralisation.

L’envers du décor

Du coup, quid des partages de l’individu lambda ? Va-t-il soulever des gros soucis de société ? Partager son œuvre ? En fait l’individu lamba parle de lui. Il publie les photos de ses enfants (oubliant le DANGER qu’il y a derrière. Et puis son gosse, sera-t-il heureux de ses exploits sur le pot de chambre archivés, 20 ans après ?), de ses voyages. Mais c’est LUI en premier plan, transformant le concept de l’autoportrait (à la base artistique) en selfie … l’individu parle de lui, il est égoïste, il est selfish. Pour l’exemple la semaine dernière en me promenant dans l’Alcazar, j’ai pris l’ascenseur avec deux jeunes filles qui devaient avoir 13-14 ans, et qui passaient leur temps à se tirer le portrait. Mais au final quelle est l’utilité de savoir qu’Emma et Gwendoline étaient à l’Alcazar ce mercredi ? à la limite elles auraient pu faire leur selfie sur une table d’étude entre deux bouquins. Car c’est ça, faire parler de soi, quelque soit l’enjeu, même en sortant des cabinets avec une moue en cul-de-poule : il faut se monter, être beau et souriant, il faut des likes, comme dans cet épisode tellement vrai de « Black Mirror » où les gens sont jugés via leur note ! Et leur photo sera postée sur Instagram à tous les coups. Mais au final, est-ce le meilleur moyen de juger d’autres humains ? Ou est-ce plus simplement des cris d’alarmes de nos égos en souffrance ?

Le plus choquant est le concept d’ « ami ». Car l’ami Facebook est devenu une entité qui est soumise à validation, et peut du jour au lendemain être supprimé : un être humain est devenu un KLEENEX jetable, pour le moindre prétexte : rupture, dispute, absence de signe de vie, etc … On se supprime, on se bloque, on s’efface, des rituels devenus aujourd’hui quotidiens alors qu’ils n’existaient même pas il y a 20 ans de ça. Quand on était fâché, on ne se parlait plus, on ne se voyait plus. On se « jetait », mais l’acte n’était pas réellement pratiqué.

Et puis il y a le relayage des infos plates, mais ce sujet a déjà été abordé ici : phrases toutes faites, vidéos d’émissions de télé, photos mal cadrées de lieux mille fois vus : une info pauvre, pas toujours vraie. Les statuts Facebook sont constitués d’une phrase à minima, ou d’une image de phrase toute faite, et on en vient à crouler sous ce flot.

Les commentaires sont difficiles à suivre également, car on retrouve beaucoup de récits (trop) personnels ou des disputes de comptoir : car le Facebooker de base est virulent et il ne faut pas le contrarier. Ce n’est plus de l’échange simple d’avis, c’est du « moi j’ai raison, va te faire foutre », car rappelons-le, il est selfish. Regardez le nombre de matchs de boxe qu’on peut trouver, sur n’importe quelle page anodine comme par exemple celle de … « Plus belle la vie« . Juste parce qu’un épisode n’a pas plus, une COMMUNAUTÉ qui partage le même goût pour une même série s’étripe !!

Quand j’ai fait mes études d’InfoCom en 2003, on parlait déjà de pléthore d’informations … du coup là, quel serait le mot adapté ? Pourtant la bonne info existe, il suffit juste de la chercher.

Diaboliser le web ? Non !

Pourtant le web demeure, derrière ces propos sociétalement négatifs, une merveilleuse invention.

Le E-learning n’existant pas il y a 20 ans de cela. Pourtant il permet à beaucoup de gens, soucieux d’attiser leur faim de connaissances, de s’instruire. J’ai personnellement acquis mon niveau en allemand rien qu’avec des cours trouvés sur Internet ! N’oublions pas ces organismes de formation en ligne qui nous permettent également de pouvoir suivre un cursus tout en continuant d’exercer son métier. L’interactivité permet de multiplier les supports : vidéos qui vous mettent en situation, supports et exercices à télécharger et imprimer, possibilité de poser des questions et créer des communautés. Nous sommes sauvés !

J’achève ici ce constat de 10 ans de web 2.0. Au prochain épisode, je vous propose ma vision du web 3.0. qui commencé déjà à éclore. Je vous laisse sur ces mots de Tim Berners-Lee, qui évoque entre autres la charte du web. Je me rends compte également que j’ai beaucoup à dire sur ce sujet, que je viens d’en écrire beaucoup et que ceci fait office d’introduction à un projet éventuel …